Schumpeter Digest #3

Digital twins e simulazione AI-driven: rappresentazioni dinamiche di sistemi fisici complessi

Nel mondo sempre più connesso dell’Internet of Things e dell’industria 4.0, è emerso il concetto di digital twin (“gemello digitale”): una replica virtuale di un’entità fisica – che sia un macchinario, un processo industriale, un edificio o persino un organismo – che ne rispecchia lo stato in tempo reale e consente simulazioni dinamiche. In parole semplici, un digital twin è un modello digitale che vive in parallelo all’oggetto reale, aggiornandosi continuamente grazie ai dati provenienti da sensori e altre fonti, in modo da fungere da banco di prova virtuale e strumento di monitoraggio avanzato. L’AI-driven simulation entra in gioco perché per sfruttare appieno un gemello digitale non basta avere una copia statica: servono algoritmi di intelligenza artificiale che analizzino i dati in arrivo, predicano evoluzioni future, ottimizzino parametri e individuino anomalie. Il contesto di riferimento è quello di sistemi fisici complessi – come fabbriche, reti elettriche, città intere – dove la simulazione guidata dall’AI offre un vantaggio strategico nel comprendere e governare fenomeni altrimenti ingestibili in tempo reale a occhio nudo.

Diffusion models e generazione controllata: architetture probabilistiche per contenuti sintetici

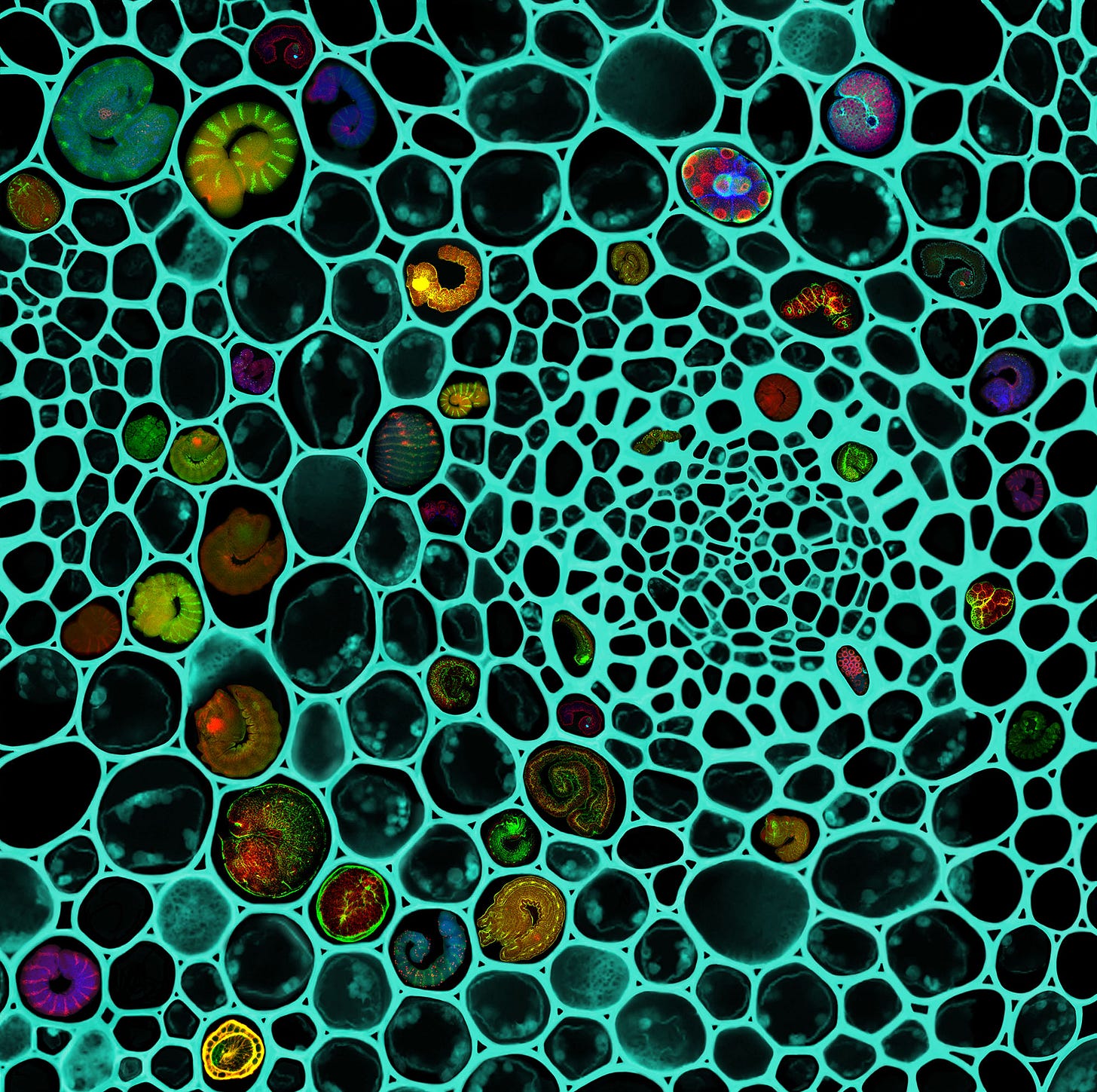

Negli ultimi anni, i modelli a diffusione (diffusion models) si sono affermati come uno degli approcci più all’avanguardia per la generazione di contenuti sintetici ad alta qualità, in particolare nel campo delle immagini, ma con estensioni anche ad audio e altri domini. Si tratta di modelli generativi probabilistici che si ispirano a processi fisici di diffusione: l’idea chiave è di definire un processo stocastico in due fasi opposte. In fase di addestramento (diffusione “diretta”), si aggiunge progressivamente rumore gaussiano ai dati reali, passo dopo passo, finché i dati originali non diventano poco distinguibili da puro rumore. Poi il modello impara a invertire questo processo, cioè a partire da rumore casuale cercare di toglierlo passo dopo passo ricostruendo dati plausibili (fase di “denoising”). In pratica, si stabilisce una catena di Markov di T piccoli passi di corruzione del dato e il modello di rete neurale è addestrato a realizzare l’operazione inversa: prevedere, dato un input rumoroso, la distribuzione del dato un passo prima (leggermente meno rumoroso). Iterando questo procedimento inverso, il modello può iniziare da input completamente casuali e generare campioni nuovi che assomigliano ai dati di addestramento. A differenza di altre famiglie di modelli generativi (come le GAN – Generative Adversarial Networks), i diffusion models hanno il vantaggio di una procedura di apprendimento più stabile e di offrire un controllo più esplicito sul processo generativo, a costo però di un maggiore sforzo computazionale per produrre un campione (poiché deve passare attraverso molti passi di denoising).

Modelli multimodali: integrazione di linguaggio, immagini, audio e video in un’unica architettura AI

I modelli multimodali rappresentano una frontiera dell’IA in cui un’unica rete è in grado di comprendere e generare informazioni provenienti da diverse modalità comunicative, come testo, immagini, audio e video. Questa integrazione mira a imitare la naturale capacità umana di correlare stimoli visivi, sonori e linguistici per ottenere una visione più ricca della realtà. Senza entrare nei dettagli tecnici, è importante notare che l’IA multimodale si colloca in un contesto in cui le applicazioni richiedono un’interpretazione congiunta di più fonti informative – ad esempio comprendere una descrizione testuale riferita a un’immagine – aprendo nuove possibilità di interazione e analisi rispetto ai modelli tradizionali che operano su un solo tipo di dato.

Self-supervised learning: apprendimento senza etichette in contesti informativi complessi

Nell’ambito del machine learning, l’apprendimento auto-supervisionato (self-supervised learning, SSL) rappresenta una metodologia in cui un modello impara a estrarre conoscenza dai dati non etichettati, sfruttando segnali di supervisione che provengono dagli stessi dati. Si parla di “auto-supervisione” perché il dataset non richiede annotazioni manuali esterne: invece, si definiscono compiti ausiliari (pretext tasks) che il modello può ricavare da caratteristiche intrinseche del dato. In un certo senso, il modello impara a risolvere puzzle o indovinelli ricavati dai dati grezzi, e così facendo sviluppa rappresentazioni interne ricche e utili. Questo approccio sta assumendo un ruolo chiave soprattutto nell’era dei big data, in cui abbiamo a disposizione enormi quantità di testo, immagini, audio non etichettati. L’idea di fondo è che l’AI possa imparare dal mondo in modo più simile a come fanno gli esseri viventi, osservando pattern e regolarità, senza che ogni concetto debba essergli esplicitamente etichettato da un supervisore umano.